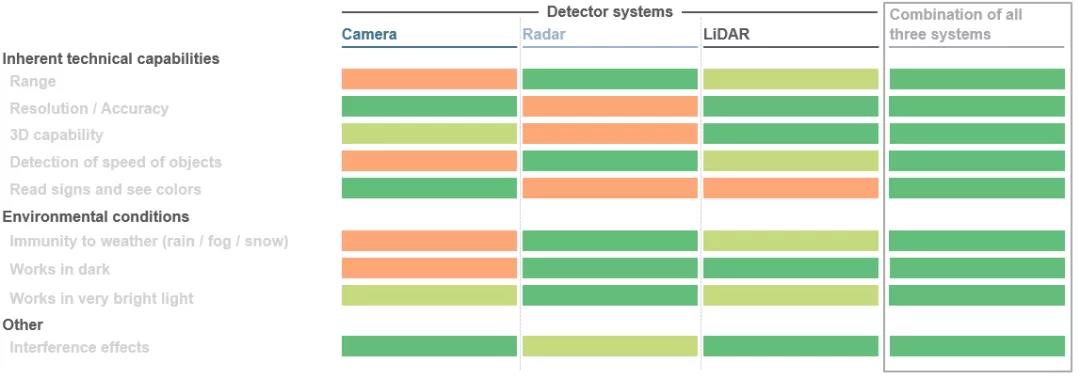

In der Mobilität vollzieht sich ein gewaltiger Sprung. Sei es im Automotive-Bereich, wo autonome Fahrlösungen entwickelt werden, oder in industriellen Anwendungen mit Robotik und Fahrerlosen Transportsystemen. Die verschiedenen Komponenten im Gesamtsystem müssen miteinander kooperieren und sich ergänzen. Das Hauptziel ist es, eine nahtlose 3D-Ansicht um das Fahrzeug herum zu erstellen, aus diesem Bild Objektentfernungen zu berechnen und mit Hilfe spezieller Algorithmen die nächste Bewegung des Fahrzeugs einzuleiten. Tatsächlich kommen hier drei Sensortechnologien gleichzeitig zum Einsatz: LiDAR (LiDAR), Radar und Kameras. Je nach Anwendungsfall haben diese drei Sensoren ihre eigenen Vorteile. Die Kombination dieser Vorteile mit redundanten Daten kann die Sicherheit erheblich verbessern. Je besser diese Aspekte aufeinander abgestimmt sind, desto besser wird sich das selbstfahrende Auto in seiner Umgebung zurechtfinden.

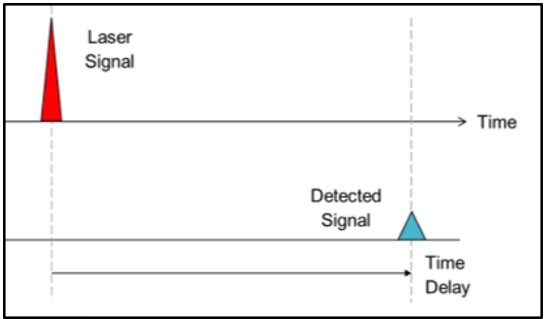

1. Direkte Flugzeit (dToF):

Beim Time-of-Flight-Ansatz nutzen Systemhersteller die Lichtgeschwindigkeit, um Tiefeninformationen zu generieren. Kurz gesagt, es werden gerichtete Lichtimpulse in die Umgebung geschossen, und wenn der Lichtimpuls auf ein Objekt trifft, wird er reflektiert und von einem Detektor in der Nähe der Lichtquelle aufgezeichnet. Durch die Messung der Zeit, die der Strahl benötigt, um das Objekt zu erreichen und wieder zurückzukommen, kann die Objektentfernung bestimmt werden, während bei der dToF-Methode die Entfernung eines einzelnen Pixels bestimmt werden kann. Die empfangenen Signale werden schließlich verarbeitet, um entsprechende Aktionen auszulösen, beispielsweise Ausweichmanöver des Fahrzeugs, um Kollisionen mit Fußgängern oder Hindernissen zu vermeiden. Dieses Verfahren wird als direkte Flugzeit (dToF) bezeichnet, weil es mit der genauen "Flugzeit" des Strahls zusammenhängt. LiDAR-Systeme für autonome Fahrzeuge sind ein typisches Beispiel für dToF-Anwendungen.

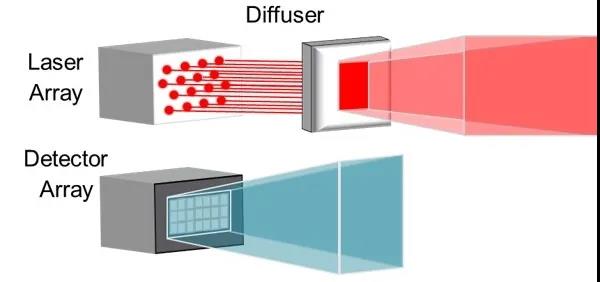

2. Indirekte Flugzeit (iToF):

Der indirekte Time-of-Flight (iToF)-Ansatz ist ähnlich, aber mit einem bemerkenswerten Unterschied. Die Beleuchtung von einer Lichtquelle (normalerweise ein Infrarot-VCSEL) wird durch eine Ausweichfolie verstärkt und Impulse (50 % Einschaltdauer) werden in ein definiertes Sichtfeld emittiert.

Im nachgeschalteten System löst ein gespeichertes „Normsignal“ den Melder für eine gewisse Zeit aus, wenn das Licht nicht auf ein Hindernis trifft. Unterbricht ein Objekt dieses Standardsignal, kann das System anhand der resultierenden Phasenverschiebung und der Zeitverzögerung der Impulsfolge die Tiefeninformation jedes definierten Pixels des Detektors ermitteln.

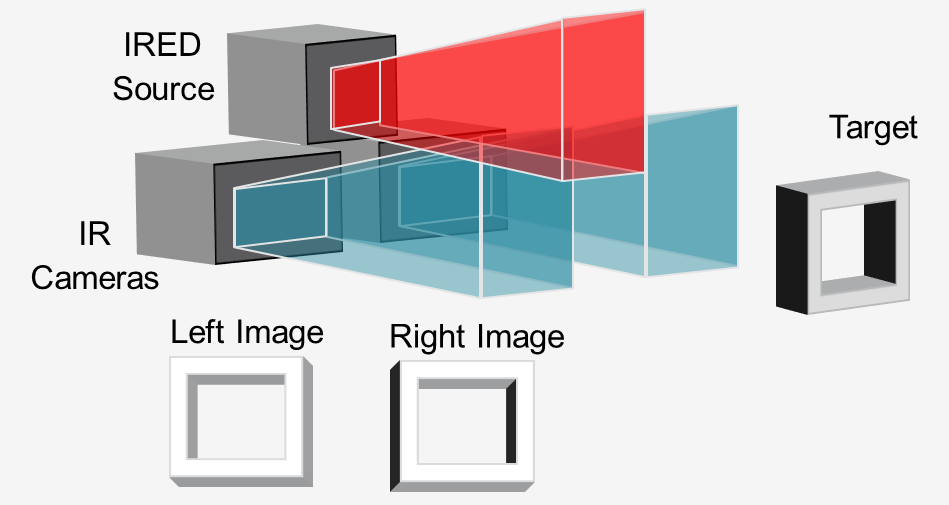

3. Aktives Stereosehen (ASV)

Beim „Active Stereo Vision“-Verfahren beleuchtet eine Infrarotlichtquelle (normalerweise ein VCSEL oder IRED) die Szene mit einem Muster, und zwei Infrarotkameras nehmen das Bild in Stereo auf.

Durch den Vergleich der beiden Bilder kann eine nachgeschaltete Software die benötigten Tiefeninformationen errechnen. Lichter unterstützen Tiefenberechnungen, indem sie ein Muster projizieren, selbst auf Objekte mit wenig Textur wie Wände, Böden und Tische. Dieser Ansatz ist ideal für die hochauflösende 3D-Erkennung aus nächster Nähe an Robotern und fahrerlosen Transportfahrzeugen (AGVs) zur Vermeidung von Hindernissen.

Copyright @ 2020 Shenzhen Box Optronics Technology Co., Ltd. – China Glasfasermodule, Hersteller von fasergekoppelten Lasern, Lieferanten von Laserkomponenten. Alle Rechte vorbehalten.